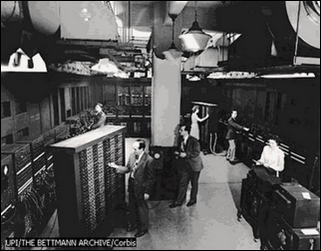

Estos computadores utilizaban la válvula de vacío. Por lo que eran equipos sumamente grandes, pesados y generaban mucho

calor.

La Primera Generación se inicia con la instalación comercial del UNIVAC construida por Eckert y Mauchly. El

procesador de la UNIVAC pesaba 30 toneladas y requería el espacio completo de un salón de 20 por 40 pies.

El

Transistor Compatibilidad Limitada sustituye la válvula de vacío utilizada en la primera generación. Los computadores de la segunda generación erán más rápidas, más pequeñas y con menores necesidades de ventilación. Estas computadoras también utilizaban

redes de núcleos magnéticos en lugar de tambores giratorios para el almacenamiento primario. Estos núcleos contenían pequeños anillos de material magnético, enlazados entre sí, en los cuales podían almacenarse datos e instrucciones.

Los programas de computadoras también mejoraron.

COBOL desarrollado durante la 1era generación estaba ya disponible comercialmente. Los programas escritos para una

computadora podían transferirse a otra con un mínimo esfuerzo. El escribir un

programa ya no requería entender plenamente el

hardware de la

computación.

Circuitos Integrados, Compatibilidad con Equipo Mayor, Multiprogramación, Minicomputadora

Las computadoras de la tercera generación emergieron con el

desarrollo de los

circuitos integrados (pastillas de silicio) en las cuales se colocan miles de componentes electrónicos, en una

integración en miniatura. Las computadoras nuevamente se hicieron más pequeñas, más rápidas, desprendían menos calor y eran energéticamente más eficientes.

Antes del advenimiento de los

circuitos integrados, las computadoras estaban diseñadas para aplicaciones

matemáticas o de

negocios, pero no para las dos cosas. Los circuitos integrados permitieron a los fabricantes de computadoras incrementar la flexibilidad de los programas, y estandarizar sus

modelos.

La IBM 360 una de las primeras computadoras comerciales que usó circuitos integrados, podía realizar tanto

análisis numéricos como

administración ó procesamiento de

archivos. Los

clientes podían escalar sus

sistemas 360 a modelos IBM de mayor tamaño y podían todavía correr sus programas actuales. Las computadoras trabajaban a tal

velocidad que proporcionaban la capacidad de correr más de un programa de manera simultánea (multiprogramación).

Microprocesador, Chips de

memoria, Microminiaturización

Dos mejoras en la

tecnología de las computadoras marcan el inicio de la cuarta generación: el reemplazo de las memorias con núcleos magnéticos, por las de chips de silicio y la colocación de Muchos más componentes en un Chip:

producto de la microminiaturización de los circuitos electrónicos. El tamaño reducido del microprocesadory de chips hizo posible la creación de las computadoras personales (PC)

En 1971, intel Corporation, que era una pequeña compañía fabricante de semiconductoresubicada en Silicon Valley, presenta el primer

microprocesadoro Chip de 4 bits, que en un espacio de aproximadamente 4 x 5 mm contenía 2 250

transistores. Este primer microprocesador que se

muestra en la figura 1.14, fue bautizado como el 4004.

Silicon Valley (Valle del Silicio) era una región agrícola al sur de la bahía de San Francisco, que por su gran producciónde silicio, a partir de 1960 se convierte en una zona totalmente industrializada donde se asienta una gran cantidad de

empresas fabricantes de

semiconductores y

microprocesadores. Actualmente es conocida en todo el mundo como la región más importante para las

industrias relativas a la computación: creación de programas y fabricación de componentes.

Actualmente ha surgido una enorme cantidad de fabricantes de microcomputadoras o computadoras personales, que utilizando diferentes estructuraso arquitecturas se pelean literalmente por el

mercado de la computación, el cual ha llegado a crecer tanto que es uno de los más grandes a nivel mundial; sobre todo, a partir de 1990, cuando se logran sorprendentes avances en

Internet.

Esta generación de computadoras se caracterizó por grandes

avances tecnológicos realizados en un

tiempo muy corto. En 1977 aparecen las primeras microcomputadoras, entre las cuales, las más famosas fueron las fabricadas por Apple Computer,

Radio Shack y Commodore

Busíness Machines. IBM se integra al mercado de las microcomputadoras con su

Personal Computer (figura 1.15), de donde les ha quedado como sinónimo el nombre de PC, y lo más importante; se incluye un

sistema operativo estandarizado, el MS- DOS (

MicroSoft Disk Operating System).

Cada vez se hace más difícil la identificación de las

generaciones de computadoras, porque los grandes avances y nuevos descubrimientos ya no nos sorprenden como sucedió a mediados del siglo XX. Hay quienes consideran que la cuarta y quinta generación han terminado, y las ubican entre los años 1971-1984 la cuarta, y entre 1984-1990 la quinta. Ellos consideran que la sexta generación está en desarrollo desde 1990 hasta la fecha.

Siguiendo la pista a los acontecimientos tecnológicos en

materia de computación e

informática, podemos puntualizar algunas fechas y características de lo que podría ser la quinta generación de computadoras.

Con base en los grandes acontecimientos tecnológicos en materia de microelectrónica y computación (

software) como CADI CAM, CAE, CASE,

inteligencia artificial,

sistemas expertos,

redes neuronales,

teoría del caos,

algoritmos genéticos, fibras ópticas,

telecomunicaciones, etc., a de la década de los años ochenta se establecieron las bases de lo que se puede conocer como quinta generación de computadoras.

Hay que mencionar dos grandes avances tecnológicos, que sirvan como parámetro para el inicio de dicha generación: la creación en 1982 de la primera supercomputadora con capacidad de

proceso paralelo, diseñada por Seymouy Cray, quien ya experimentaba desde 1968 con supercomputadoras, y que funda en 1976 la Cray Research Inc.; y el anuncio por parte del

gobierno japonés del

proyecto "quinta generación", que según se estableció en el acuerdo con seis de las más grandes empresas japonesas de computación, debería terminar en 1992.

El proceso paralelo es aquél que se lleva a cabo en computadoras que tienen la capacidad de trabajar simultáneamente con varios microprocesadores. Aunque en teoría

el trabajo con varios microprocesadores debería ser mucho más rápido, es necesario llevar a cabo una programación especial que permita asignar diferentes tareas de un mismo proceso a los diversos microprocesadores que intervienen.

También se debe adecuar

la memoria para que pueda atender los requerimientos de los

procesadores al mismo tiempo. Para solucionar este problema se tuvieron que diseñar módulos de memoria compartida capaces de asignar áreas de caché para cada procesador.

Según este proyecto, al que se sumaron los países tecnológicamente más avanzados para no quedar atrás de

Japón, la característica principal sería la aplicación de la inteligencia artificial (Al, Artificial Intelligence). Las computadoras de esta generación contienen una gran cantidad de microprocesadores trabajando en paralelo y pueden reconocer voz e

imágenes. También tienen la capacidad de comunicarse con un lenguaje natural e

irán adquiriendo la habilidad para tomar decisiones con base en

procesos de

aprendizaje fundamentados en sistemas expertos e inteligencia artificial.

El almacenamiento de información se realiza en dispositivos magneto ópticos con capacidades de decenas de Gigabytes; se establece el

DVD (Digital VideoDisk o Digital Versatile Disk) como estándar para el almacenamiento de

video y

sonido; la capacidad de almacenamiento de datos crece de manera exponencial posibilitando guardar más información en una de estas unidades, que toda la que había en la

Biblioteca de Alejandría. Los componentes de los microprocesadores actuales utilizan tecnologías de alta y ultra integración, denominadas VLSI (Very Large Sca/e Integration) y ULSI (Ultra Lar- ge Scale Integration).

Sin embargo, independientemente de estos "milagros" de la tecnología moderna, no se distingue la brecha donde finaliza la quinta y comienza la sexta generación. Personalmente, no hemos visto la realización cabal de lo expuesto en el proyecto japonés debido al fracaso, quizás momentáneo, de la inteligencia artificial.

El único pronóstico que se ha venido realizando sin interrupciones en el transcurso de esta generación, es la conectividad entre computadoras, que a partir de 1994, con el advenimiento de la

red Internet y del

World Wide Web, ha adquirido una importancia vital en las grandes, medianas y pequeñas empresas y, entre los usuarios particulares de computadoras.

El propósito de la Inteligencia Artificial es equipar a las Computadoras con "Inteligencia Humana" y con la capacidad de razonar para encontrar

soluciones. Otro factor fundamental del

diseño, la capacidad de

la Computadora para reconocer patrones y secuencias de procesamiento que haya encontrado previamente, (programación Heurística) que permita a la Computadora recordar resultados previos e incluirlos en el procesamiento, en esencia, la Computadora aprenderá a partir de sus propias experiencias usará sus Datos originales para obtener la respuesta por medio del razonamiento y conservará esos resultados para posteriores tareas de procesamiento y toma de decisiones.